DeepSeek podbijają rynek AI z kolejnej strony. Możecie przetestować ich Janusa Pro

Oprócz debiutu ich modelu językowego DeepSeek-R1, chiński startup DeepSeek wypuścił również generatywne modele graficzne, Janus, JanusFlow i Janus-Pro-7b. Ukazały się w serwisie GitHub i tak jak poprzedni, są modelem open-source, dostępnym do uruchomienia lokalnie, nawet bez dostępu do internetu. Potrzebny jest tylko odpowiednio silny komputer.

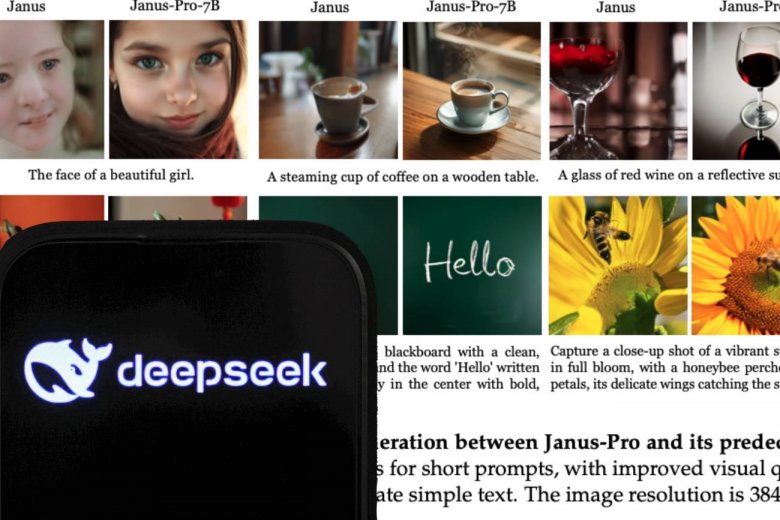

Obrazki z Janus Pro

Z całej tej rodzinki Janus Pro zadebiutował wczoraj, a jego możliwościom poświęcono artykuł na serwisie HuggingFace. Najnowsza i najbardziej zaawansowana wersja swojsko kojarzącego się Janusa ma generować obrazki lepiej i skutecznie niż zachodnie modele, a do tego różni się od nich architekturą.

Jeśli chcemy sami sprawdzić, co potrafi Janus Pro, potrzebujemy komputera wyposażonego przynajmniej w kartę graficzną GeForce 16 GB VRAM, pamięć RAM 16 GB i 20 GB wolnego miejsca na dysku

"W sercu Janus Pro leży przełomowa, zunifikowana architektura transformatorów, która odróżnia go od konwencjonalnych modeli AI. W systemie zastosowano innowacyjne podejście polegające na rozdzieleniu kodowania wizualnego na osobne ścieżki, co zapewnia doskonałą wydajność zarówno w zadaniach związanych ze zrozumieniem obrazu, jak i jego tworzeniem. Ten projekt architektoniczny pozwala Janusowi Pro obsługiwać złożone operacje multimodalne z niezwykłą wydajnością" – czytamy na HuggingFace.

Wedle dokumentacji oznacza to, że tworzy obrazki wyższej jakości w rozdzielczości 384x384 pikseli i oprócz tego jeszcze ma lepiej rozumieć intencję użytkownika i analizę obrazów. Czyli być intuicyjny przy pracy, precyzyjniejszy, a do tego z możliwością edytowania detali na wygenerowanych treściach. I potencjalnie nie popełniając obraźliwych wtop, które zdarzają się innym modelom.

Do tego ma nie mieć problemu z napisami umieszczanymi na grafice, co Chińczycy dumnie prezentują na przykładowych grafikach.

Gamechanger w AI czy marketingowy szum?

Janus-Pro ma prześcignąć istniejące modele generatywnej AI, jak DALL-E 3, dzięki zoptymalizowanemu treningowi, na większej liczbie jakościowych danych. Wytrenowano go na ponad 90 mln próbek w tym 72 mln "syntetycznych punktów danych estetycznych", co ma zapewniać wydajność i atrakcyjność generowanych obrazów.

Pojawiają się pytania o transparentność DeepSeek – od infrastruktury centrum danych po sposób pozyskania sprzętu. Amerykańskie ograniczenia dotyczące eksportu chipów mogą dodatkowo zaostrzyć tę debatę w najbliższych miesiącach.

DeepSeek nie podało wiele więcej informacji o treningu tego modelu. Chociaż twierdzą, że ich AI powstają dużo taniej niż amerykańskie, pojawia się sporo głosów, w tym z WallStreet, które kwestionują deklaracje chińczyków.

Czytaj także: https://innpoland.pl/210824,wstrzasajacy-debiut-deepseek-akcje-nvidii-rekordowo-pikuja