Odkąd media społecznościowe zagościły w naszej świadomości, przypomina nam się regularnie, aby ostrożnie dzielić się informacjami. Do zasad sieciowej higieny może wkrótce dołączyć dbanie o nasz głos, bo nawet krótki fragment nagrania może wystarczyć dla cyberprzestępców do np. upozorowania porwania.

Krótkie formy wideo trwające około minuty, spopularyzowane przez TikToka, są dostępne na wielu platformach. Są szczególnie popularne wśród młodzieży, np. w formie wyzwań, czasem przybierających skrajne formy.

Jeśli młodzież nie stosuje żadnych filtrów, to może się okazać, że któregoś dnia rodzice usłyszą zrozpaczony głos swojego dziecka, proszącego, aby zapłacić za nie okup. Bądź dziadkowie dostaną telefon z prośbą o duże pieniądze. Jak wyjaśniają nam eksperci z ESET, takie scenariusze są realnym zagrożeniem.

Jak przestępcy używają deepfake?

Świat poznał już pierwsze próby wyłudzenia pieniędzy z użyciem technologii deepfake. Ba, o zagrożeniu tej technologii mówi się cały czas, a na INNPoland pisaliśmy o tym już w 2019 roku. Eksperci z ESET zauważają, że właśnie docieramy do momentu, gdy rysowane wtedy najgorsze scenariusze mogą się zrealizować.

– Głos sklonowany przez AI jest już teraz wystarczająco przekonujący, aby oszukać nawet bliskich członków rodziny. Co więcej, takie rozwiązania AI są na tyle szeroko dostępne, że przestępcy bez większego trudu mogą z nich skorzystać. Dzięki AI możliwe jest przygotowanie pliku dźwiękowego z dowolnym tekstem, za pomocą głosu wygenerowanego na podstawie nagrań wideo, które bardzo często sami umieszczamy w social mediach. Wiemy już, że tego rodzaju technologie do tworzenia deepfake'ów będą się rozwijać i niedługo mogą stać się powszechnym narzędziem cyberprzestępców – mówi Kamil Sadkowski, analityk laboratorium antywirusowego ESET.

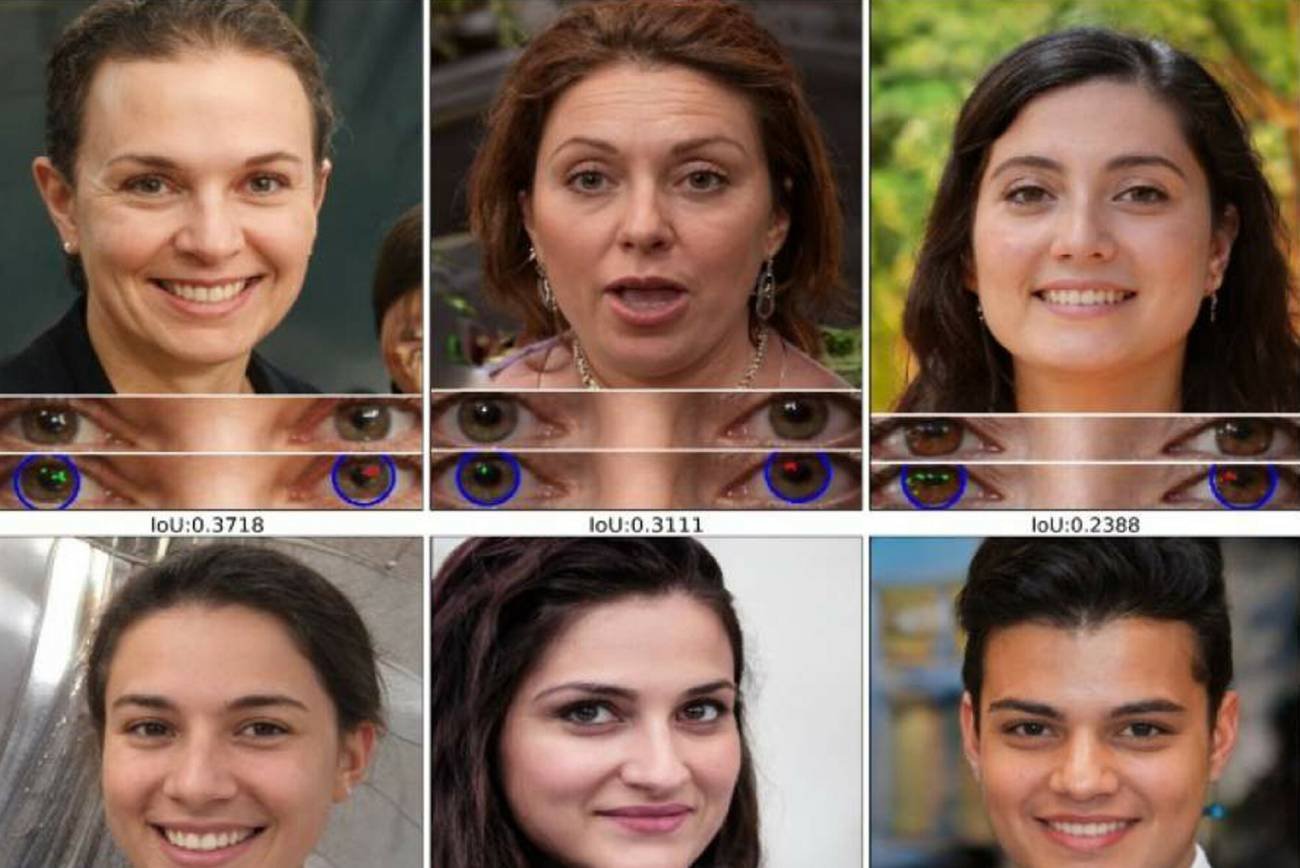

Nie potrzeba wiele, by stworzyć deepfake. Fragment nagrania głosu, zdjęcia, twarz w kamerze. Młodzież bardzo chętnie umieszcza filmy w sieci ze swoim udziałem, przez co cyberprzestępcy mają łatwy dostęp do materiałów, jakie mogą zostać wykorzystane w oszustwie.

Jak tworzy się "wirtualne porwania"?

Po ustaleniu celu, od którego cyberprzestępcy chcą wyłudzić pieniądze, poszukują następnie wygodnej ofiary "porwania". Zwykle wybiera się na nie dzieci. Tworzą następnie scenariusz, który zagwarantuje, że odbierająca wiadomość osoba będzie wstrząśnięta i podejmie nieracjonalne decyzje. Zmuszą ją przy tym, by działała natychmiast.

Dogodny moment do ataku odnajdują również za pomocą badania mediów społecznościowych, np. wybierając osoby na wakacjach, jak przytrafiło się to Amerykance Jennifer DeStefano. Nagrania na których występuje obiekt "porwania" wykorzystywane są też, aby zdobyć informacje, jakie mają potwierdzić tożsamość dziecka. Eksperci informują nas, że oszuści zwykle chcą zapłaty w sposób trudny do prześledzenia, np. kryptowalutami.

Możemy oczywiście pomyśleć, że takie wirtualne porwania to problem bogatych amerykanów - nie zapominajmy jednak, że w Polsce nadal plagą są różne "metody na wnuczka" wyłudzające pieniądze od seniorów. Metody, przed jakimi ostrzegają eksperci z ESET, mogą łatwo znaleźć zastosowanie do takich celów.

Zobacz także

Jak się uchronić?

W teorii powinno być łatwo zweryfikować oszustwo - wystarczy skontaktować się z rzeczywistym krewnym. Niestety przestępcy mają i na to sposób, nazywający się SIM swapping. W ramach tej techniki kontaktują się oni z operatorem telekomunikacyjnym, podszywając się pod właściciela telefonu i prosząc o przeniesienie numeru ofiary na nową kartę SIM. W ten sposób uniemożliwiają weryfikację porwania, bo nasza bliska osoba nie odbiera telefonu.

Zdaniem ekspertów od ESET są jednak inne metody, dzięki czemu można zminimalizować ryzyko stania się ofiarą wirtualnego porwania i innych oszustw z wykorzystaniem deepfake. Możemy np. zainstalować aplikacje pozwalające na geolokalizację na telefonach naszych bliskich

Kamil Sadkowski

Analityk laboratorium antywirusowego ESET

Co jeszcze zdradza nasze dane? Ekspert ostrzega przed wiadomościami phishingowymi, których celem jest właśnie wyłudzanie informacji, które mogą być wykorzystane do zorganizowania "porwania" albo "telefonu od wnuczka".

Jeśli zaś chcemy zabezpieczyć głos naszych bliskich, a np. nie odbierać im przyjemności z dzielenia się materiałami w Internecie, przypomnijmy o stosowaniu filtrów czy aplikacji przetwarzających tekst na neutralną mowę.

Kiedy podejrzewamy, że rozmawiamy z oszustwem, działają zawsze sprawdzone metody - czyli zachowajmy spokój i poinformujmy o zajściu policję. Mimo opisanej na początku metody na podmianę karty SIM zawsze warto zadzwonić do osoby, z którą rzekomo rozmawiamy o jej "porwaniu" albo prośbie do dziadków.

AI samo zrobi filmy z tekstu

W obawie przed dezinformacją i niebezpiecznymi zastosowaniami ich nowej sztucznej inteligencji, OpenAI rygorystycznie testuje Sorę, nim trafi ona do szerszego odbiorcy. To AI potrafi stworzyć realistyczne nagranie z samego tylko tekstu, ale może też wykorzystać istniejące materiały, by wygenerować nową treść.