"Muszę oddychać, jak każdy w trakcie mówienia” – mówi do mnie system AI. Wspierane przez sztuczną inteligencję głosy nie tylko prowadzą programy radiowe, ale również skutecznie podrywają, a nawet podszywają się pod Mateusza Morawieckiego. Albo Baracka Obamę, mówiącego, że Demokraci zlecili zamach na Trumpa.

Wciąż pamiętam sytuację, jaka przytrafiła się trzy lata temu we Wrocławiu mojej znajomej, która rozmawiała przez telefon z obsługą klienta.

– No i rozmawiam z kobietą przez telefon, ale mam wrażenie, że coś jest nie tak. Jakby ona nie do końca rozumiała, co do niej mówię. Pytam w końcu "Czy pani jest botem?". Na co ona odpowiada, że jest po prostu zmęczona godzinami rozmów przez telefon i pewnie dlatego tak brzmi. Wyobrażasz sobie, jak było mi głupio? – zapytała mnie.

Faktycznie, wyobrażałem sobie.

Wystarczająco wielu moich znajomych pracowało w różnych call-center, żebym na każdy telefon z ofertą odpowiadał moim najuprzejmiejszym głosem: "Bardzo dziękuję za telefon, życzę miłego dnia".

– I nagle rozmowa się urywa – kontynuuje opowieść moja znajoma – I słyszę "niestety nasz automatyczny asystent nie mógł przyjąć twojego zgłoszenia, zaraz nastąpi przekierowanie do konsultanta". Czyli ta kobieta nie była kobietą!

Może próba badawcza tego eksperymentu jest dość ograniczona, ale wniosek z niego jest jeden – łatwo jest się nabrać na sztuczki z technologią audio napędzaną AI.

Nawet jak jest tak archaiczna, jak asystent głosowy centrum obsługi klienta w Polsce trzy lata temu. A od tego czasu rynek audio AI przeżył cichą rewolucję. Mamy AI prowadzących w radiu i AI spoofing, czyli podszywanie się pod głos kogoś innego. A wszystko to możesz usłyszeć za pomocą zaledwie swojego telefonu.

IVONA podbija internet

Historia rozwoju technologii audio AI rozpoczyna się od najbardziej podstawowych syntezatorów mowy. Pierwszym tego typu systemem był VODER (Voice Operating Demonstrator) stworzony przez Homera Dudleya w 1939 roku.

Potrafił on do pewnego stopnia naśladować ludzką intonację, modulując odpowiedź w zależności od tego, czy zadawał pytanie, czy odpowiadał. Jego obsługa wymagała specjalnego przeszkolenia, a wykorzystywano do niej klawisze i pedały zmieniające ton głosu maszyny.

Powolny rozwój technologii syntezatorów doczekał się przełomu z polskim akcentem, kiedy to w 2001 roku firma IVONA Software wydała swoje oprogramowanie. Polski producent zdołał stworzyć syntezator, który w wyjątkowo naturalny sposób (jak na początek lat 00.) naśladował ludzką mowę.

IVONA stała się fonomenem. Jednak największą popularnością cieszyła się wśród polskich twórców internetowych.

Przeróbki filmów z użyciem jej głosu – często bardzo wulgarne – zalały wczesnego YouTube’a. Skala zjawiska była tak duża, że w tytułach przeróbek, które nie wykorzystywały polskiego syntezatora dopisywano “0 IVONA”.

Firmę wykupił w 2013 roku Amazon i przy użyciu jej oprogramowania stworzył słynnego asystenta głosowego Alexa. Wówczas polski syntezator zyskał zdolność rozpoznawania mowy i sztuczną inteligencję pozwalającą wykonywać proste polecenia.

Sztuczna inteligencja mówi

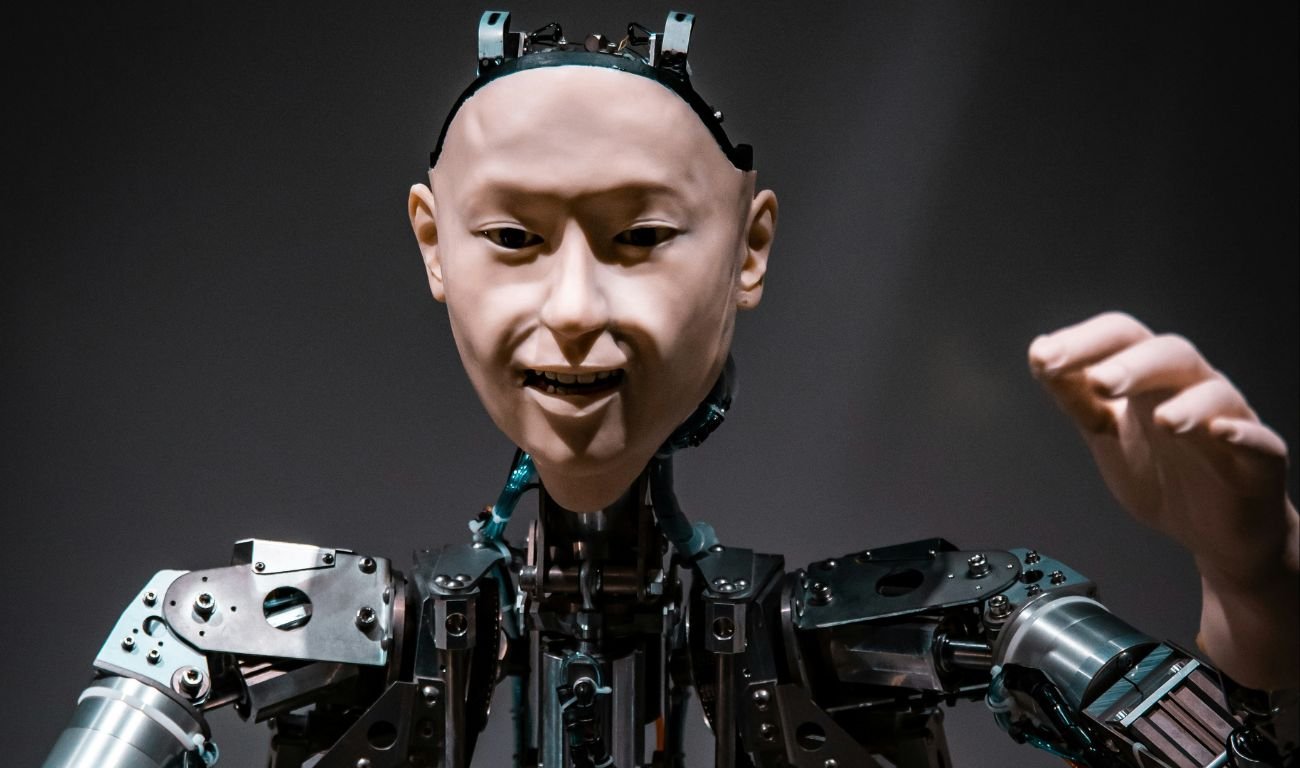

Ostatnia rewolucja technologiczna – zapoczątkowana przez wydanie dwa lata temu ChataGPT – napędziła rozwój audio AI. Modele sztucznej inteligencji, które obecnie znamy przede wszystkim w formie chatbotów, zaczynają wykorzystywać nowe media.

Ogromną popularnością zaczęły cieszyć się najpierw generatory obrazów. Systemy audio AI długo nie zyskały tak wielkiej popularności. Przełomowy moment nastąpił w tym roku. OpenAI przeprowadziło prezentację nowego modelu ich flagowego produktu. ChatGPT wraz z wersją 4o stał się wówczas pełnoprawnym asystentem głosowym.

Przyznam, że oglądając powyższą prezentację, byłem zszokowany.

Do tej pory kojarzyłem takie systemy z gotowaniem makaronu u znajomych i krzyczeniem w eter przynajmniej 3 razy “Hey Alexa, set timer for 11 minutes”.

A tutaj mamy do czynienia z idealnym odwzorowaniem ludzkiej mowy, uwzględniającym nie tylko intonację wypowiedzi, ale i przerwy na wdech czy śmiech.

Ten model rozumie ironię, a nawet potrafi z niej korzystać. Wypowiada się nie tylko naturalnie, ale i spontanicznie. Do tego, co jest zapewne najbardziej niepokojące, mam wrażenie, że całkiem skutecznie podrywa autora prezentacji.

To, jak poważnie nowy model OpenAI traktuje naśladowanie ludzkiej mowy, widzimy na nagraniu opublikowanym przez jednego z użytkowników Reddita – na którym ChatGPT 4o odmawia powiedzenia ciągiem rymowanek bez robienia przerw na oddech.

“Muszę oddychać, jak każdy w trakcie mówienia” – mówi system na nagraniu.

Audio AI, czyli generatory deepfake’ów

Ostatnio głośno zrobiło się również o nowym narzędziu od Google.

Choć Notebook LM – platforma zawierająca cały katalog narzędzi wspieranych AI, do robienia notatek i podsumowywania tekstów, istnieje już od ponad roku, wielu z nas usłyszało o niej dopiero niedawno.

To właśnie za sprawą nowej opcji generowania podcastu na podstawie wgranego materiału.

Każdy tekst, jaki dodamy na platformę (o ile jest w języku angielskim) może zostać przerobiony na rozmowę między dwoma prowadzącymi: mężczyzną i kobietą, którzy przeprowadzą nas przez dany temat.

Nie ważne, czy będzie to lektura na zajęcia, czy instrukcja obsługi odkurzacza, Notebook LM potrafi przetworzyć materiał tekstowy w dialog, uzupełniony żartami i drobnymi wtrąceniami zaczerpniętymi z sieci.

Zapewne najgłośniejszym przełomem w dziedzinie audio AI w ostatnim czasie są jednak dokonania ElevenLabs. Firma założona w 2022 roku zajmuje się wykorzystywaniem sztucznej inteligencji do tworzenia nagrań dźwiękowych.

Przy użyciu jej oprogramowania możemy stworzyć klon głosu, na podstawie zaledwie minuty nagrania. To ogromny przeskok technologiczny, zważywszy, że jeszcze niedawno podobne usługi wymagały godzin próbek dźwięku.

Ich technologia jest również odpowiedzialna za kontrowersyjny klon głosu Wisławy Szymborskiej, który mogliśmy niedawno usłyszeć na antenie OFF Radio Kraków. Dzięki ElevenLabs możemy stworzyć nagranie z naturalnie brzmiącym odczytaniem wybranego tekstu.

Głos, który wybierzemy, może również mówić w dowolnym języku. Zastanawiałeś się więc może, jak brzmiałby Stalin, mówiący po angielsku? Ja też nie, ale dzięki ElevenLabs możesz się dowiedzieć:

Audio AI – na pewno jeszcze je usłyszysz...

Rozwój systemów audio AI został przyćmiony przez inne przełomy w dziedzinie generatywnej sztucznej inteligencji. Jednak w ostatnim czasie zaczynamy o nich słyszeć coraz częściej.

Dzieje się tak po pierwsze, ponieważ komunikacja głosowa jest coraz odważniej implementowana do znanych systemów AI, takich jak ChatGPT.

Ale również dlatego, że coraz lepszej jakości nagrania stworzone przy użyciu AI stanowią realne zagrożenie. Po pierwsze mogą okazać się skutecznym narzędziem w rękach przestępców, którzy płacąc 5 dol. miesięcznie, mają dostęp do narzędzia klonowania głosu każdej osoby, której minutę nagrania uda się im pozyskać.

Mogą to wykorzystać do wyłudzania pieniędzy, ale też zastraszania i nękania konkretnych osób.

Jest to również bardzo niebezpieczne narzędzie dla naszego życia politycznego. Ze szczególnym niepokojem patrzymy na tę technologię w kontekście nadchodzących wyborów prezydenckich w USA.

Do tej pory ujawniono tylko kilka przypadków wykorzystywania technologii audio deepfake w politycznej dezinformacji. Najpoważniejszym było zapewne wygenerowane nagranie Baracka Obamy, mówiącego, że Demokraci zlecili zamach na Donalda Trumpa.

Na polskim podwórku też oczywiście znajdziemy przykłady politycznych deepfake'ów. Co ciekawe u nas za generowanie audio zabierają się same partie polityczne. Przed ubiegłorocznymi wyborami parlamentarnymi PO wypuściło spot, w którym treść maili wysyłanych przez Morawieckiego czyta klon jego głosu, wygenerowany przez syntezator mowy.