Atak samoświadomej sztucznej inteligencji jest tak samo prawdopodobny, jak atak kosmitów czy wampirów. Niestety, zagrożenia SI wyglądają mniej spektakularnie, ale znacznie bardziej życiowo. Już teraz, w tej właśnie chwili, ktoś jest profilowany i krzywdzony przez SI, komuś nie przyznano kredytu, ktoś nie dostał pracy. To ludzie i ich niedoskonałość są swoim największym wrogiem.

REKLAMA

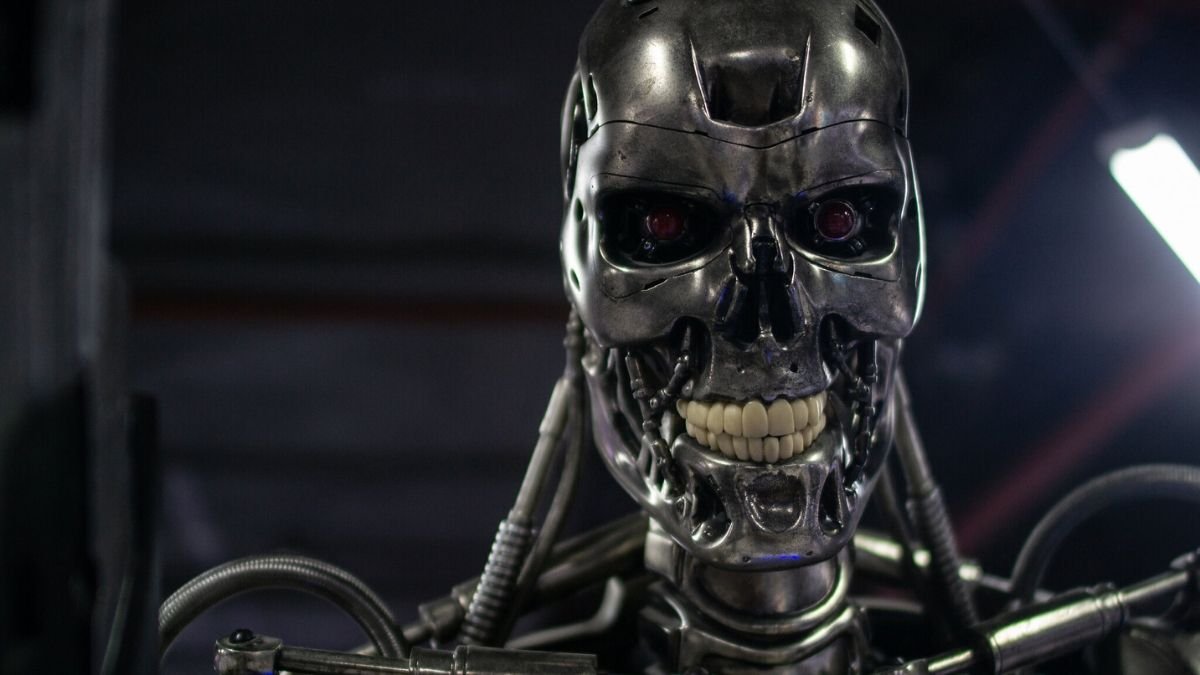

W „Terminatorze” z 1984 roku Skynet, system SI, zyskuje samoświadomość i rozpoczyna apokalipsę, której cele jest unicestwienie ludzkości. W serialu HBO „Westworld” obdarzone sztuczną inteligencją hosty mordują ludzi - nie, żeby ludziom się nie należało, ale to inna historia.

Tymczasem my, wyobrażając sobie zagrożenia SI tak, jak to sobie wymyślił Hollywood,

nie dostrzegamy mniej spektakularnych, ale nie mniej poważnych zagrożeń. Sztuczna inteligencja nie jest na tyle inteligenta, by rozpętać apokalipsę. Jest jednak na tyle szybka, by przetworzyć źle opracowane przez nas, ludzi, zbiory danych i wydać decyzję, które zaważą na jakości naszego życia, a czasem na nim samym.

nie dostrzegamy mniej spektakularnych, ale nie mniej poważnych zagrożeń. Sztuczna inteligencja nie jest na tyle inteligenta, by rozpętać apokalipsę. Jest jednak na tyle szybka, by przetworzyć źle opracowane przez nas, ludzi, zbiory danych i wydać decyzję, które zaważą na jakości naszego życia, a czasem na nim samym.

Seksistowskie algorytm?

Algorytmy sztucznej inteligencji wydają decyzje, które wpływają na bardzo wiele dziedzin naszego życia. Są powszechne m.in. na rynku pracy, na uczelniach, w medycynie, opiece społecznej czy edukacji.

Jak czytamy w raporcie „AlgoPolska. Zautomatyzowane podejmowanie decyzji w służbie społeczeństwu”, w 2014 r. Amazon opracował system automatyzacji rekrutacji, który niżej punktował CV kobiet. Profesor Vicente Ordóñez z University of Virginia, tworząc algorytmy do interpretacji obrazu, zauważył, że zdjęcia kuchni są przez jego program częściej kojarzone z kobietami niż z mężczyznami.

Joy Buolamwini z MIT przeanalizowała trzy systemy rozpoznawania twarzy – Microsoftu, IBM-u i Megvii. Ich skuteczność sięgała 99 proc., ale tylko w przypadku białych mężczyzn. W odniesieniu do czarnoskórych kobiet spadała nawet do 35 proc.

Algorytmy wymknęły się spod kontroli? Niekoniecznie.

To my jesteśmy zagrożeniem

We wszystkich opisanych powyżej przypadkach problemem były „stronnicze” dane wejściowe. W bazie CV Amazona zdecydowaną większość kandydatów stanowili mężczyźni. Profesor Ordóñez używał wielkich repozytoriów otagowanych zdjęć z zasobów Google’a i Facebooka, które w dużej mierze powielały stereotypy podziału ról. Podobnie było w przypadku algorytmu rozpoznającego twarz. Na zdjęciach, z których korzystała SI, w 75 proc. byli mężczyźni, a 80 proc. wszystkich osób stanowili biali.

Zapewne znasz takie powiedzenie „jesteś tym, co jesz”. Parafrazując, można powiedzieć, że algorytm jest tym, co je. A co je? Dane, które mu dostarczmy. I tu zaczynają się poważne problemy. Aby algorytmy mogły pełnić swoją rolę, tzn. podejmować decyzję, dostrzegać zależności i tworzyć predykacje, muszą najpierw otrzymać od nas, ludzi, pokaźną bazę danych.

– „Nakarmione” kiepskiej jakości danymi sieci neuronowe mogą m.in. dyskryminować ludzi, powielając społeczne stereotypy, albo też np. pokazywać błędne diagnozy, które nie są adekwatne do sytuacji i stanu pacjenta. Z kolei w przypadku sektora finansów coraz częściej stosowane przez banki systemy oparte na SI mogą nie udzielić komuś kredytu tylko przez to, że ta osoba mieszka w dzielnicy o stosunkowo niskim poziomie średnich dochodów – wyjaśnia dr Aleksandra Przegalińska, ekspertka z zakresu sztucznej inteligencji z Akademii Leona Koźmińskiego.

Decyzje, które zagrażają życiu

Niestety, w przeciwieństwie do nas nie potrafią myśleć zdroworozsądkowo. Wszystko, co od nas otrzymują, przyjmują za normę i na tej podstawie budują swoją „mądrość”. Niezdarnie i na siłę dopasowują wzorce statystyczne w oparciu o coraz większe ilości danych.

Jak czytamy w raporcie „AlgoPolska”, w 2017 roku w Danii system Watson wykorzystano do rutynowych badań profilaktycznych raka piersi. Jedynie w 27 proc. przypadków rekomendacje Watson Oncology zgadzały się z decyzjami lekarzy dotyczącymi leczenia.

W tym przypadku nie było już jednak mowy o dyskryminacji czy seksizmie, a o ludzkim życiu. 63 proc. rekomendacji, które wydał algorytm, było błędnych, z czego przynajmniej połowa mogła zaważyć na życiu. Na szczęście te decyzje został zweryfikowane.

W tym przypadku nie było już jednak mowy o dyskryminacji czy seksizmie, a o ludzkim życiu. 63 proc. rekomendacji, które wydał algorytm, było błędnych, z czego przynajmniej połowa mogła zaważyć na życiu. Na szczęście te decyzje został zweryfikowane.

Na razie zdecydowana większość systemów zautomatyzowanego podejmowania decyzji wciąż zawiera istotny aspekt decyzji człowieka. W takim układzie komputery raczej sugerują decyzje niż je autonomicznie podejmują. Nie oznacza to jednak, że takie systemy są mniej niebezpieczne.

Za bardzo ufamy technologi

– Po pojawieniu się wczesnych systemów ostrzegania o awarii silników w samolotach, piloci zaufali im na tyle, że okazało się w testach, że wykrywali… mniej awarii niż wtedy, gdy musieli obserwować sytuację wyłącznie swoimi oczami! – przypomina Bartosz Paszcza, ekspert ds. nowych technologii z Klubu Jagiellońskiego, współautor raportu „AlgoPolska – zautomatyzowane podejmowanie decyzji w służbie społeczeństwu”.

Podobny los może czekać samochody autonomiczne. Branża z uwagą przygląda się osiągnięciom Tesli i koncernu Google. Ten ostatni regularnie udostępnia raporty, z których wynika, że jego autonomiczne auta przebywają coraz większą liczbę kilometrów bez usterki i bez stworzenia sytuacji niebezpiecznych dla ruchu.

– Jako ludzie łatwo darzymy maszyny ogromnym zaufaniem. Po kilkunastu lub kilkudziesięciu poprawnych sugestiach algorytmu uczymy się mu ufać, zaczynamy polegać na decyzjach sugerowanych przez komputer, a zaoszczędzony czas i energię poświęcać innym zadaniom – wyjaśnia Bartosz Paszcza.

Choć wykonują arcytrudne obliczenia, to nie są zdroworozsądkowe i etyczne

Nawet doskonale zaprojektowany samochód autonomiczny, nie będzie jednak w stanie uniknąć wypadku, awarii czy innego zdarzenia, co z kolei rodzi spore wątpliwości. Samochód będzie musiał bowiem podjąć „etyczną” decyzję: co zrobić? Tu kłania nam się leciwy, a wciąż aktualny tzw. "dylemat wagonika".

Nie podejmie jej jednak sam. Wszystko będzie zależało od tego, jak zostanie zaprogramowany. AI wykonuje skompilowane działania matematyczne, gromadzi ogromne ilości danych, a do tego wszystkiego uczy się kolektywnie, co znacząco wyróżnia ją spośród nas.

Nie oznacza to jednak, że komputery są mądrzejsze od nas. SI nie działa i nie będzie działała jak nasz mózg. Nie podejmie decyzji w oparciu o moralność i etykę.

Tylko czy programiści będą potrafili podejmować etyczne wybory. A co jeśli umiejętność programowania posiądzie drugi Hitler? Jeśli twórca algorytmu będzie uważać jeden rejon świata za bezpieczny, a drugi za wrogi. A co najgorsze, jeśli programista nie będzie świadomy swoich uprzedzeń?

Równie dobrze sztuczna inteligencja może być wykorzystana do tworzenia broni autonomicznej, co już jest w najwyższym stopniu wątpliwe.

Nie możemy zostawić AI programistom

– Jako społeczeństwo nauczyliśmy się w bardzo wysokim stopniu wypracowywać reguły prawidłowego i etycznego postępowania wobec siebie nawzajem, to dlaczego nie mielibyśmy tego zrobić wobec komputerowych reguł? Na przykład, na początku dwudziestego wieku wypracowaliśmy zbiór reguł i zasad pomagających regulować i normować powstawanie leków – pyta Bartosz Paszcza.

Elon Musk w dokumencie „Czy wierzysz temu komputerowi” snuje zaś wizję dyktatury robotów mówiąc, że: "Jeśli jednej firmie lub małej grupie ludzi uda się rozwinąć boską superinteligencję, mogą przejąć kontrolę nad światem”. Wizja przejęcia, choć nieprawdopodobna, w obliczu kwestii etycznych, wydaje się całkiem realna. Jak temu przeciwdziałać?

Tak jak razem wypracowywaliśmy reguły etycznego postępowania, tak razem powinniśmy projektować algorytmy. Zespoły nad nimi pracujące powinny być zróżnicowane środowiskowo, kulturowo i geograficznie. W ten sposób zminimalizujemy ryzyko wadliwych algorytmów, wypaczonych danych, a przed wszystkim ich wykorzystanie przez szalone jednostki.