Były amerykański żołnierz Matthew Livelsberger zmagał się ze stresem pourazowym po powrocie z Afganistanu. W Nowy Rok popełnił samobójstwo wysadzając wynajętą Teslę Cybertruck. W przygotowaniach do ataku pomógł mu ChatGPT.

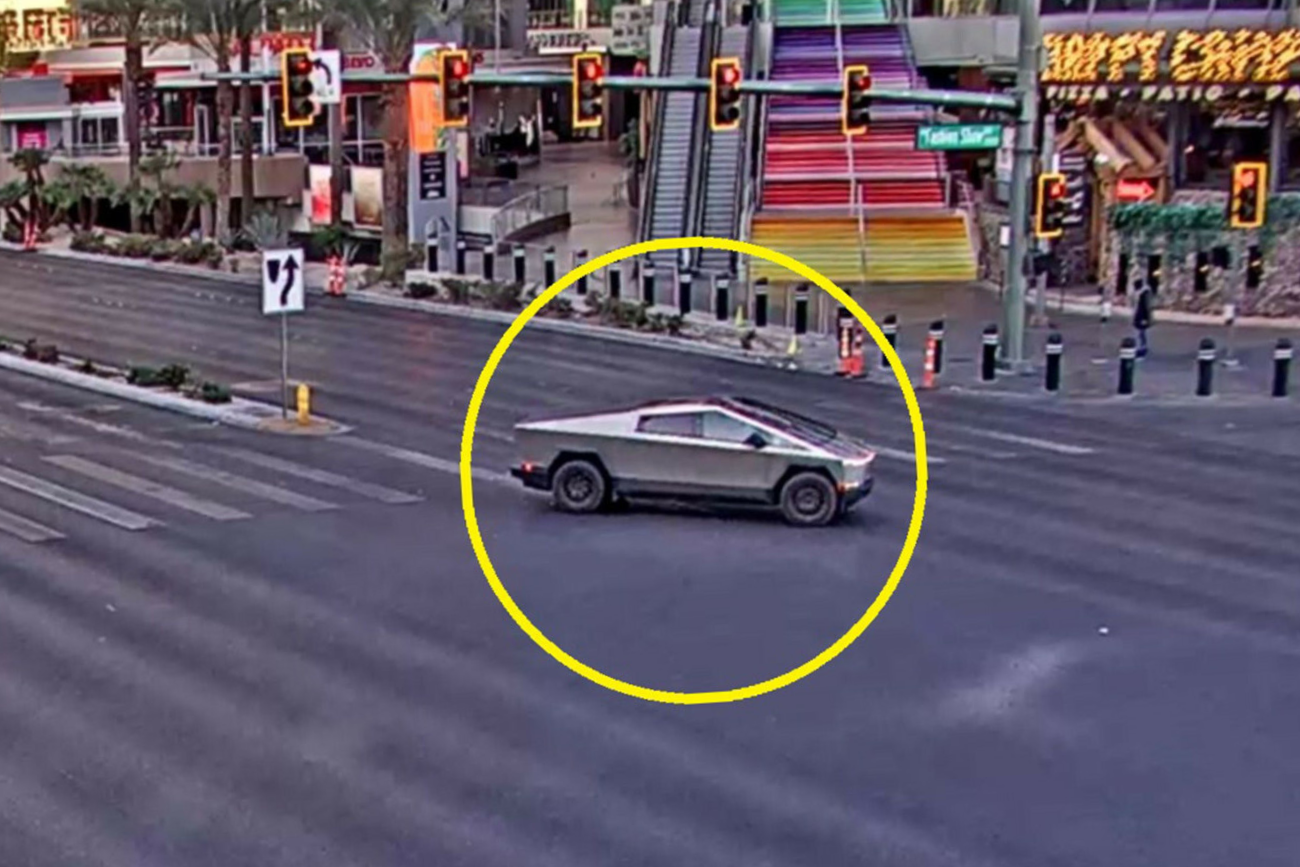

Matthew Livelsberger, żołnierz amerykańskich Zielonych Beretów popełnił samobójstwo poprzez wysadzenie Tesli Cybertruck, w której był zamknięty. Zrobił to w Nowy Rok przed Trump International Hotel w Las Vegas. W przygotowaniach do zamachu pomógł mu ChatGPT.

To pierwszy znany przypadek użycia generatywnej sztucznej inteligencji w takim celu.

Samobójstwo Matthew Livelsbergera

Livelsberger, weteran wojny w Afganistanie, najpierw postrzelił się, a następnie zdetonował materiały wybuchowe i fajerwerki w wynajętym Cybertrucku.

W wyniku eksplozji nie zginęli inni ludzie, ale siedem osób zostało rannych.

Śledczy wskazali, że Livelsberger zmagał się z zespołem stresu pourazowego (PTSD) i innymi problemami psychicznymi. W notatce pozostawionej przed śmiercią pisał o poczuciu winy związanym z wojną, utracie kolegów oraz ciężarze życia.

Livelsberger w swoim przesłaniu określił Stany Zjednoczone jako "kraj terminalnie chory i zmierzający ku upadkowi". Swoje działania nazwał "próbą obudzenia społeczeństwa". Wspomniał również o Elonie Musku, którego określił jako osobę kluczową dla przyszłości USA. Wzywał także do wsparcia Donalda Trumpa, prezydenta elekta.

Sztuczna inteligencja pomogła w zaplanowaniu ataku

Policja w Las Vegas ujawniła, że Livelsberger skorzystał z ChataGPT do zbierania informacji na temat eksplozji, prędkości i zasięgu kul oraz legalności fajerwerków w Arizonie (są dozwolone przez 27 dni w roku).

Chociaż ChatGPT jest zaprogramowany tak, by odmawiać odpowiedzi na szkodliwe pytania, w tym przypadku udzielał informacji na podstawie informacji dostępnych w internecie, jednocześnie ostrzegając przed nielegalnymi działaniami.

Stanowisko OpenAI

OpenAI, firma odpowiedzialna za rozwój ChataGPT, wyraziła żal z powodu tego zdarzenia i zobowiązała się do współpracy z organami ścigania. Rzecznik firmy podkreślił, że modele AI są zaprojektowane tak, by minimalizować potencjalne zagrożenia, ale jednocześnie zaznaczył, że narzędzie w tym przypadku nie wygenerowało unikalnych, nielegalnych instrukcji, a jedynie wykorzystało ogólnodostępne dane.

Choć nie jest jasne, czy Livelsbergerowi udało się uzyskać od ChatuGPT szczegółowe instrukcje dotyczące budowy materiałów wybuchowych, incydent ten pokazuje, jak nowe technologie mogą zostać wykorzystane w nieoczekiwany i niebezpieczny sposób.