Studio Niantic wykorzysta dane ze swoich gier mobilnych do stworzenia modelu sztucznej inteligencji, który bez problemu będzie nawigował w przestrzeni. Dzięki zbieraniu stworków ma skorzystać cały świat. Oraz, rzecz jasna, sami gracze.

W listopadowym wpisie blogowym Niantic, twórcy gier Pokemon Go, Monster Hunter Now i Peridot, ogłosili się pionierami LGM – dużego geoprzestrzennego modelu. To ma być sztuczna inteligencja, która rozumie, jak rozłożona jest przestrzeń dookoła niej, a do tego potrafi ją ulokować w szerszym kontekście. Danych dostarczają jej miliony graczy. Trochę skomplikowanie brzmi, ale zaraz wszystko wyjaśnimy.

Pokemon Go uczy sztuczną inteligencję

Aby przekonać się o ograniczaniach technologii AI, nie trzeba daleko szukać. Coca-Cola uraczyła nas reklamami świątecznymi, które składają się z serii pociętych kadrów. Brak tutaj ciągłości, nie ma dłuższych ujęć pokazujących przejazd ciężarówek. A wystarczy zmienić odrobinę kąt i samochody zmieniają kształty.

Sztuczna inteligencja, czy generatywna, czy obsługująca roboty i auta, ma problemy z rozumieniem przestrzeni tak jak my. Chodzi nie tylko o orientację w terenie, ale i oglądanie obiektów z różnych kątów i budowanie ciągów skojarzeń. Stąd te nieszczęsne auta Coca-Coli wyglądają za każdym razem inaczej, czasem gdy tylko kamera trochę się przesunie.

Dla maszyny wóz widziany z innego kąta może być łatwiejszy do zobrazowania nowym modelem niż wyobrażenia sobie, że to ten sam pojazd. Gdy AI brakuje informacji, generuje nowe na podstawie dostępnych danych. Stąd się biorą słynne tzw. halucynacje. Nie wie, jak poznać, czy grzyb jest jadalny? Zaproponuje, żebyś go zjadł.

Niantic, Eric Brachmann i Victor Adrian Prisacariu

Wpis "Building a Large Geospatial Model to Achieve Spatial Intelligence"

Jak Niantic przekracza tę poprzeczkę z pomocą gier? Wykorzystuje w nich VPS (wirtualny system pozycjonowania), z którego pomocą wytrenował 50 milionów sieci neuronowych opartych o 150 bilionów parametrów, wykorzystując dane z ponad miliona lokacji. Uf! Dzięki temu nasz stworek w Pokemon Go w trybie rzeczywistości rozszerzonej siedzi w jednym miejscu, a jak się od niego oddalimy, to zachowują się zasady perspektywy.

Na te ogromne liczby składają się np. skany obiektów w ramach zadania "Scan PokeStop". Polega ono na obchodzeniu dookoła wybranego punktu, np. tablicy informacyjnej, obserwując je przez obiektyw, póki gra nie powie dość. Jako gracz przyznam, że u mnie zawsze się kurzą – chodzenie dookoła miejsc w przestrzeni publicznej jest upierdliwe dla mnie i innych ludzi.

Zobacz także

Zebrane dane służą do stworzenia globalnego dużego modelu inteligencji, który bez skanowania potrafi rozeznać się w przestrzeni geograficznej i zrozumieć np. że statua widziana od frontu ma plecy, które są jej częścią. Albo, że jak podejdzie do danego budynku od boku, załapie, że wejście frontowe jest gdzie indziej. Uwzględni odległości, głębię, perspektywę.

Znów – co dla człowieka jest oczywiste, dla algorytmów bywa czarną magią.

[Aktualizacja 29.11]

Niantic podkreśla, że funkcja skanowania jest opcjonalna i potwierdza, że samo chodzenie i rozgrywka nie są używane w modelu AI.

Niantic

materiał prasowy

Co przyniesie taka technologia?

Co jednak oznacza to zwykłych ludzi? Niantic ma nadzieje, że technologia znajdzie szerokie zastosowanie, chociażby w urządzeniach noszonych, od smartwatchy po okulary do rzeczywistości rozszerzonej. Rozwinie narzędzia nawigacyjne, desingowe i logistyczne. Do tego przyda się robotom i systemom autonomicznym. Przykładowo samochodom oferują perspektywę nie z samej tylko drogi, ale oczami pieszego. Wedle Niantic będzie to "przyszłość światowych systemów operacyjnych".

Już teraz ich system VPS pozwala na podstawie zdjęcia ustalić położenie użytkownika na świecie. Nie mówiąc o tym, że ich gry mobilne przydają się do orientacji w przestrzeni i odnajdywania ciekawych miejsc na mapie. Chyba każdy gracz w produkcje Niantic chociaż raz użył ich do nawigacji.

Co nowego w Pokemon Go w 2024 roku?

Gra przeszła niezłą ewolucję od szału w 2016 roku. W tym roku padło kilka kontrowersyjnych decyzji, jak nowe modele awatarów gracza (nie bez powodu zasłoniłem swojemu twarz) i walki MAX. Za to zapowiada się coś świetnego dla miłośników interakcji z uroczymi kreaturami.

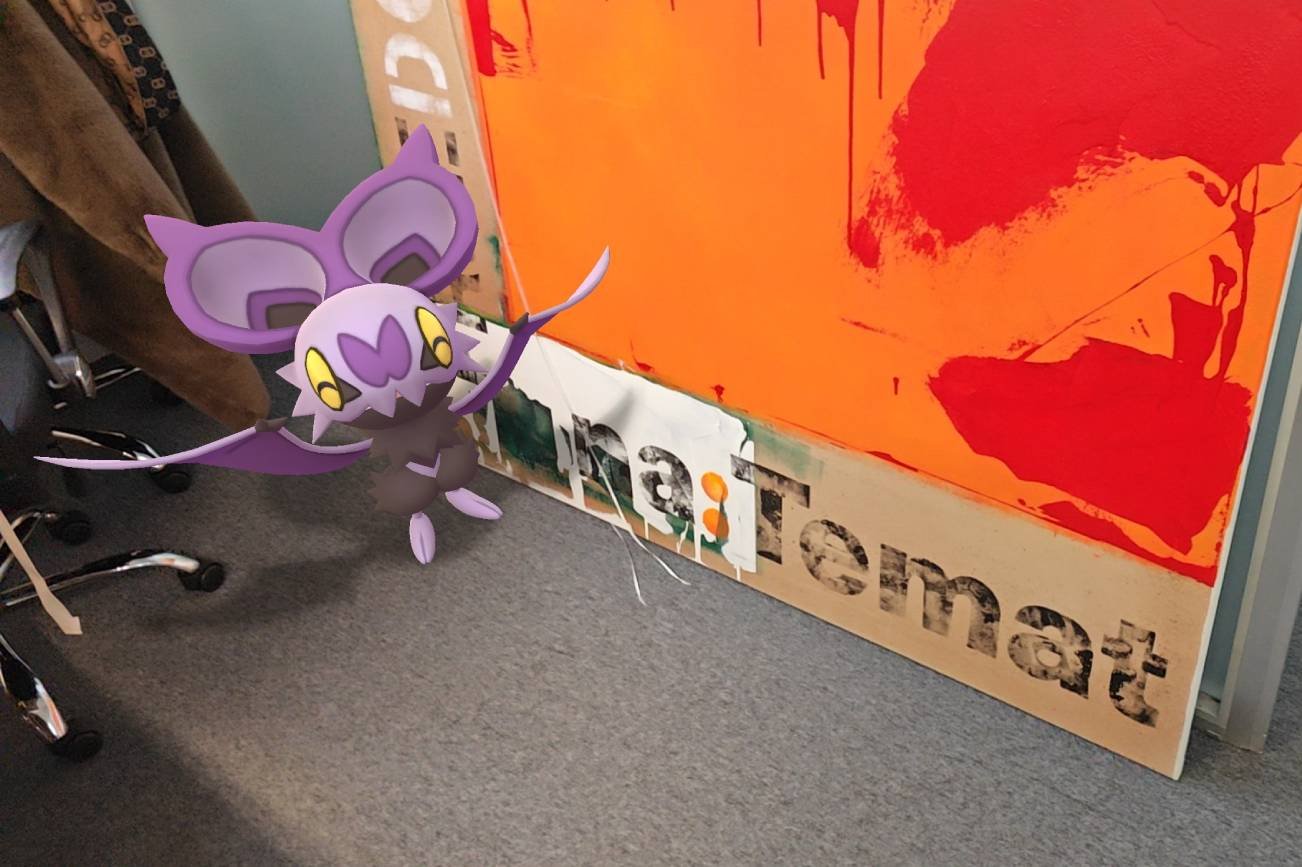

Przykładem użycia technologii VPS jest właśnie zapowiadana funkcja "Pokemon Playgrounds". Pozwala zostawić nam stworka w przestrzeni i innym użytkownikom go odnaleźć w celach interakcji. Jest testowana w wybranych miejscach, jak widzimy na poniższym przykładzie.

Tak jak obecnie nasz towarzysz w trybie AR biega po podłodze i nie wpada na obiekty, tak pokemony na placu zabaw będą widoczne dla każego. System VPS przypisze je co do centymetra do przestrzeni, dzięki czemu wszyscy gracze będą widzieć je zgodnie z perspektywą i fizyczną pozycją.

Ja czekam i mam nadzieję, że uda nam się zrobić redakcyjny wybieg. Jeśli technologia LGM rozwinie się jak obiecuje Niantic, zapowiada się, że w przyszłości stworki będą rozpoznawać obiekty dookoła siebie i być może urządzą sobie gonitwę dookoła naszych biurek.