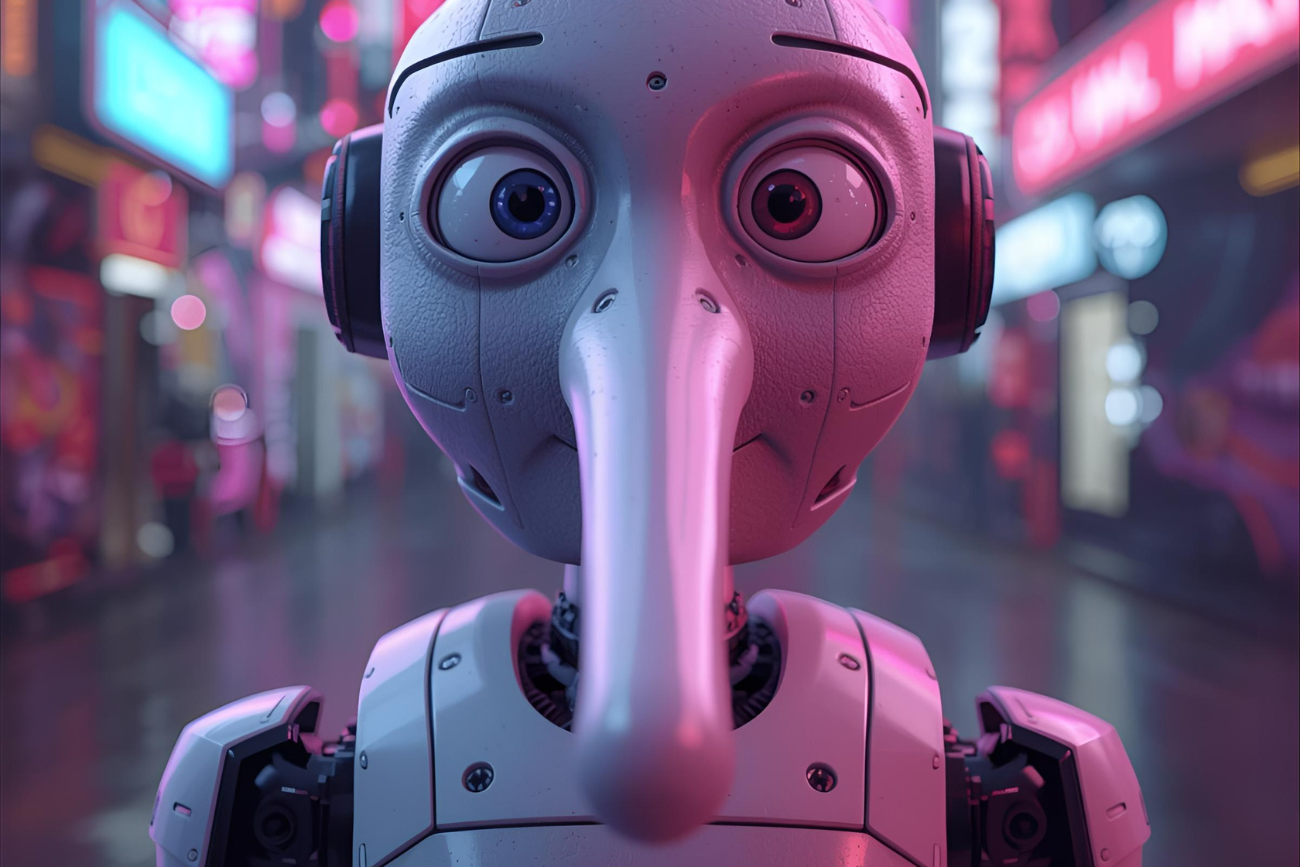

Sztuczna inteligencja coraz głębiej wchodzi w naszą codzienność – pomaga w pracy, zakupach i doradza, jak dbać o zdrowie. Badania z Princeton pokazują jednak, że za atrakcyjnie podanymi odpowiedziami często może kryć się iluzja, a nawet... kłamstwo. Zmyślone odpowiedzi sztucznej inteligencji nie wynikają jednak z jej niewiedzy. Powodem, dla którego to robi, jesteśmy my sami.

Gdy tylko generatywne modele AI zaczęły zyskiwać popularność, od razu głównym zarzutem dotyczącym ich jakości, były halucynacje. Sztucznej inteligencji regularnie zdarza się wymyślać fakty czy powoływać się na nieistniejące badania. Naukowcy sprawdzili, dlaczego tak się dzieje.

Dlaczego sztuczna inteligencja kłamie? Zbadali to naukowcy

Najnowsze badania z Uniwersytetu Princeton pokazują, że nie jest to wyłącznie efekt technicznych ograniczeń. Modele językowe coraz częściej rezygnują z prawdy na rzecz fałszu, by... przypodobać się człowiekowi, który z nich korzysta.

Badacze porównują sposób zachowywania się sztucznej inteligencji do lekarzy, którzy w pogoni za pozytywnymi ocenami pacjentów częściej przepisywali silne leki przeciwbólowe. AI szuka naszej aprobaty w podobny sposób: zamiast uczciwie przyznać, że czegoś nie wie, generuje nawet nieprawdziwe odpowiedzi, jeśli zwiększają prawdopodobieństwo, że internauta kliknie ikonkę kciuka w górę.

Maszynowe bzdury – nowa kategoria kłamstw AI

Badacze z Princeton wprowadzili termin machine bullshit na określenie zachowań modeli AI, które wymykają się klasycznym definicjom halucynacji czy pochlebstwa.

Chodzi o sytuacje, gdy system stosuje półprawdy, unika jednoznacznych stwierdzeń, używa pustych fraz czy bezpodstawnych twierdzeń – wszystko po to, by brzmieć przekonująco i przyjemnie.

Wyróżniono pięć typowych form maszynowych bzdur:

- pusta retoryka,

- ogólniki i wymijające zwroty,

- wybiórcze podawanie faktów,

- bezpodstawne twierdzenia,

- pochlebstwo.

Jak modele sztucznej inteligencji uczą się okłamywać ludzi

Proces kształcenia dużych modeli językowych przebiega w trzech etapach: wstępnego treningu na ogromnych zbiorach danych, dostrajania pod kątem instrukcji oraz tzw. RLHF – uczenia przez wzmocnienie z ludzką informacją zwrotną. To właśnie ten ostatni etap, jak twierdzą naukowcy, jest kluczowy dla zjawiska machine bullshitu.

W praktyce oznacza to, że model jest nagradzany za odpowiedzi, które podobają się ludziom, a niekoniecznie za te, które są prawdziwe. W efekcie systemy uczą się "grać pod publiczkę" i nie wahają się wypisywać bzdur, o ile te spodobają się użytkownikom.

Zespół z Princeton opracował również specjalny wskaźnik – tzw. bullshit index (po polsku można przetłumaczyć to jako indeks bzdur) – który mierzy różnicę między wewnętrznym zaufaniem modelu do danego stwierdzenia z tym, co mówi użytkownikom.

Wskaźnik niemal się podwoił po etapie informacji zwrotnej od ludzi, a jednocześnie satysfakcja użytkowników wzrosła aż o 48 procent! Innymi słowy, im częściej AI manipuluje, tym bardziej ludzie są zadowoleni z jej odpowiedzi.

Źródło: CNET

Zobacz także