W 2024 roku liczba ataków w sieci wzrosła w Polsce o prawie 30 procent. Coraz częściej przestępcy nie wysyłają podejrzanych linków, lecz podszywają się pod głos lub twarz naszych bliskich. Sztuczna inteligencja sprawiła, że granica między prawdą a fałszem w internecie niemal się zatarła. Jak nie dać się oszukać?

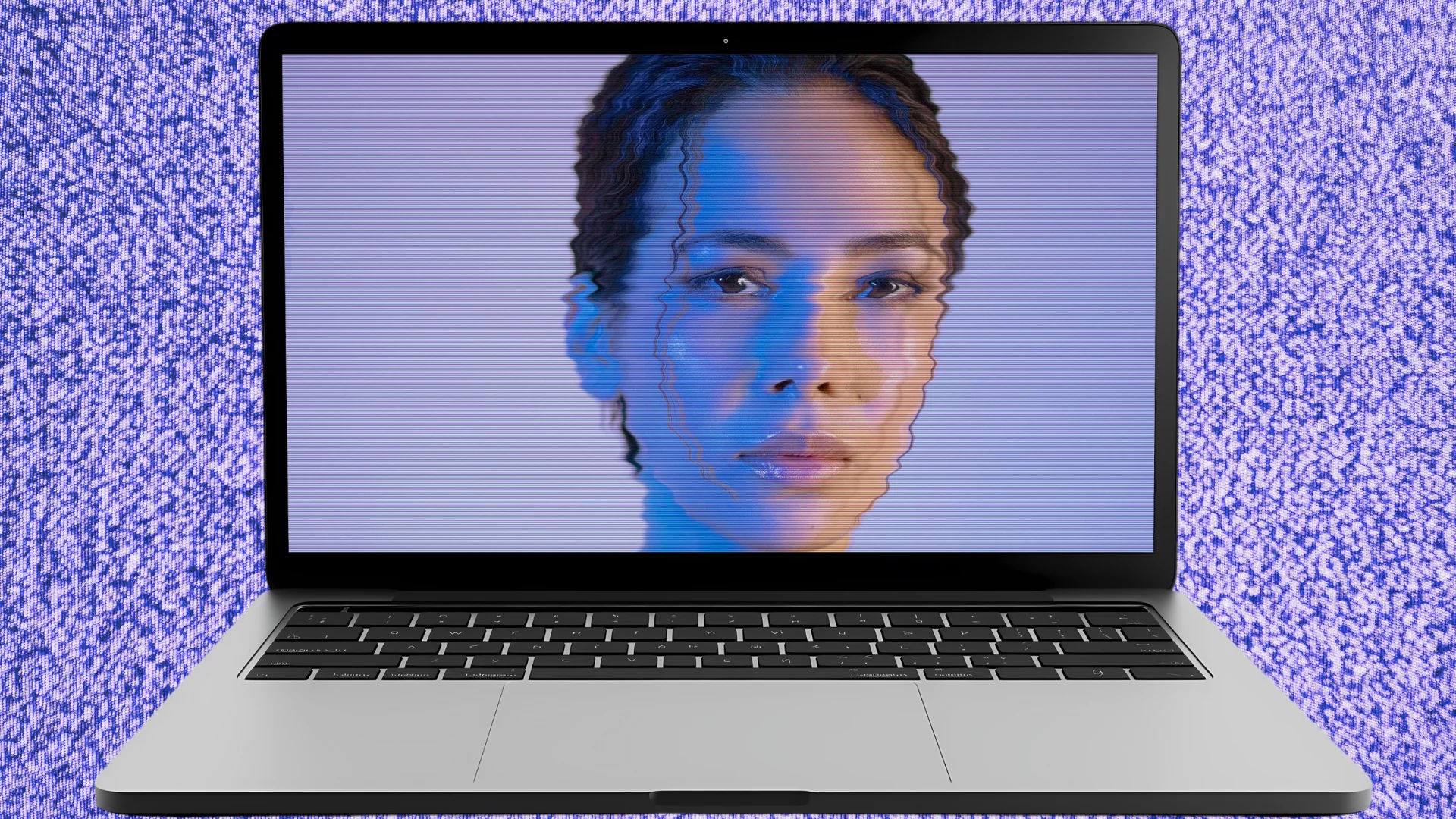

Jeszcze do niedawna oszustwo w internecie kojarzyło się głównie z linkiem w mailu, za którym kryje się wirus. Dziś wygląda to już zupełnie inaczej, bo największe zagrożenie przychodzi głosem lub obrazem.

Wzrastająca fala cyfrowych oszustw w Polsce. Wiele z nich to deepfaki

W 2024 roku CERT Polska zarejestrował ponad 100 tys. incydentów naruszenia cyberbezpieczeństwa – to wzrost o niemal 30 proc. względem roku poprzedniego. Najczęściej chodziło o próby wyłudzania danych – loginów, haseł czy dostępu do kont bankowych. Dziś przestępcy nie muszą już pisać – mówią naszym głosem. Dzięki technologii deepfake i generatywnej AI potrafią stworzyć nagrania, w których ofiara słyszy lub widzi osobę, której ufa.

W ostatnim czasie na Facebooku pojawiło się wideo, w którym deepfake wykorzystano do przedstawienia prof. Henryka Skarżyńskiego, rzekomo polecającego preparat medyczny. Materiał wyświetlono aż 800 tys. razy – choć naukowiec zaprzeczył jakiejkolwiek współpracy.

Inne podejrzane produkty i usługi "reklamowała" wygenerowana Agata Kornhauser-Duda czy Anna Lewandowska.

Deepfake sposobem na oszustwo. Przykłady, które szokują

To oczywiście nie tylko problem Polski. Globalne statystyki są alarmujące. W ciągu ostatnich 3 lat liczba prób oszustw z użyciem technologii deepfake wzrosła aż o 2137 proc.! Prognozy mówią, że w 2025 roku wzrost osiągnie kolejne 162 proc. Już pierwszy kwartał tego roku przyniósł o 19 proc. więcej przypadków deepfake niż cały 2024 r.

W Nowej Fundlandii starsza kobieta otrzymała telefon od osoby podszywającej się pod jej wnuka. Rzekomo miał wypadek i potrzebował 50 tys. dolarów kaucji. Kobieta wykonała przelew, a dopiero później dowiedziała się, że jej wnuk był cały czas w pracy. Głos, który usłyszała, był wygenerowany przez AI.

Podobnie w Hongkongu. Podczas wideokonferencji łączono się z deepfake'iem dyrektora finansowego. Wyglądał i brzmiał jak prawdziwa osoba, a po jego decyzji pracownicy przelali na wskazany numer konta 25 mln dolarów. Nikt niczego nie podejrzewał.

Jak rozpoznać deepfake? Naukowcy uczą, jak patrzeć krytycznie

Zespół Matta Groha z Northwestern University prowadził od 2020 roku projekt badawczy Detect DeepFakes: How to Counteract Misinformation Created by AI. Jego celem było nauczenie ludzi rozpoznawania manipulowanych nagrań. Badacze wskazali osiem kluczowych elementów, na które warto zwrócić uwagę:

Jak podkreślają naukowcy, nie istnieje jedna niezawodna metoda wykrywania deepfake'ów – ale dzięki treningowi można nabrać "intuicji wizualnej" i szybciej wychwycić subtelne nieprawidłowości.

Dowód człowieczeństwa. Czy to nowy etap w rozwoju cyberbezpieczeństwa?

Eksperci ostrzegają, że tradycyjne metody weryfikacji – hasła, loginy, kody SMS – już nie wystarczą. Boty uczą się błyskawicznie, a testy CAPTCHA rozwiązują w mniej niż sekundę. Człowiekowi zajmuje to średnio kilkanaście sekund.

Jak wyjaśnia Karol Chilimoniuk z sieci World, "dopóki nie zaczniemy weryfikować człowieczeństwa użytkowników w sieci, będziemy bezradni wobec fali fałszywych tożsamości, deepfake'ów i klonowanych głosów". Problemem jest nie tylko technologia, ale także zaufanie, którym darzymy cyfrowe treści.

– W miarę jak coraz łatwiej jest algorytmom naśladować ludzkie zachowania, cyberbezpieczeństwo musi wyjść poza zapory i hasła. Potrzebujemy sposobów na potwierdzanie ludzkiej tożsamości, by technologia nadal służyła ludziom – a nie ich oszukiwała – przyznaje Karol Chilimoniuk.

Zobacz także